Uso de la evaluación formativa en formación del profesorado de Educación Física en Educación Secundaria: un estudio de caso

Use of formative assessment in Physical Education teacher education in Secondary School: a case study

Sonia Asún-Dieste, Marta Guíu Carrera

Uso de la evaluación formativa en formación del profesorado de Educación Física en Educación Secundaria: un estudio de caso

Cultura, Ciencia y Deporte, vol. 18, núm. 55, 2023

Universidad Católica San Antonio de Murcia

Sonia Asún-Dieste  * sonasun@unizar.es

* sonasun@unizar.es

Universidad de Zaragoza, España

Marta Guíu Carrera

Instituto de Enseñanza Secundaria La Marina, España

Recibido: 23 abril 2022

Aceptado: 27 noviembre 2022

Resumen: La introducción de un modelo educativo por competencias en la docencia universitaria hace emerger el debate sobre la superación de los métodos de evaluación tradicionales por nuevos sistemas, como lo es la evaluación formativa. El presente estudio tiene por objetivo analizar el nivel de presencia de evaluación formativa en asignaturas generales y específicas de la formación del profesorado de Educación Física del Máster Universitario en Profesorado de Educación Secundaria Obligatoria, Bachillerato, Formación Profesional y Enseñanzas de Idiomas, Artísticas y Deportivas de una universidad pública española y explorar las percepciones del profesorado sobre la misma. Para ello, se realiza un estudio de caso de diseño mixto complementario cuantitativo y cualitativo en el que se obtienen datos de doce asignaturas a partir del Instrumento de análisis de sistemas de evaluación de las guías docentes (IASEG) y de las entrevistas en profundidad realizadas a cinco profesores. Los resultados muestran el uso de evaluación formativa sin que se hayan constatado diferencias significativas entre asignaturas generales y específicas. Por otra parte, se detecta diversidad entre docentes, en cuanto al conocimiento de este modo de evaluación e implementación del mismo en la asignatura. En definitiva, se observa un interés incipiente en este tipo de evaluación; sin embargo, se evidencian obstáculos, como un contexto poco habituado a esta práctica y la falta de formación de algunos docentes.

Palabras clave: evaluación, educación superior, guías docentes.

Abstract: The adoption of a competencies-based education model in university teaching brings up the debate on the overtaking of traditional assessment methods by new systems, such as the formative assessment. The aim of this study is to analyse, the level of presence of formative assessment in general and specific subjects in Physical Education teacher education in the Master's Degree in Teaching in Secondary, Baccalaureate, Vocational Training and Teaching of Languages, Arts and Sports in a Spanish Public University and explore teachers’ perceptions of it. Therefore, a mixed quantitative and qualitative complementary design case study is carried out, in which data is obtained from the Instrument for the analysis of the teaching guides’ assessment systems (IASEG) of twelve subjects and in-depth interviews with five teachers. The results show the use of formative assessment with no significant differences between general and specific subjects. On the other hand, diversity is detected among teachers in terms of their knowledge of this mode of assessment and its implementation in the subject. In conclusion, an incipient support is observed for this type of assessment; however, there are obstacles such as the limitations generated by a context that isn’t used to this practice and the lack of training of some teachers.

Keywords: assessment, higher education, teaching programme.

Introducción

La evaluación representa uno de los aspectos más controvertidos en el ámbito universitario. Considerándose una prioridad para los estudiantes universitarios y una obligación para el profesorado, todavía no se ha llegado a un claro consenso sobre cuál es el sistema de evaluación que resulta más adecuado en la formación universitaria. De hecho, el modelo de evaluación al que se enfrentan los estudiantes en su vida universitaria no es único y varía mucho en función de las creencias del profesor que lo diseña, las directrices de los centros y las normativas. En cualquier caso, investigaciones recientes muestran que parece evidente un predominio de modelos tradicionales de evaluación, en los que el examen final tiene la máxima importancia (Panadero et al., 2019). Sin embargo, gracias al cambio de paradigma en la universidad tras la reforma de títulos universitarios basados en competencias (Álvarez et al., 2014), surgen nuevos modelos de evaluación más ajustados y coherentes con el aprendizaje que los existentes con anterioridad, en los que prima siempre la sanción y la clasificación del alumnado y no tanto el desarrollo máximo de su competencia. En este nuevo contexto, el debate se polariza y los profesores comienzan a tomar decisiones sobre el uso de los diferentes modelos. Sin duda, se hace necesaria una actitud de responsabilidad, que debería provenir del compromiso, así como de la formación que poseen en ese momento (López et al., 2015).

La evaluación formativa

La evaluación es un proceso en el que se recoge y se analiza información con objeto de describir la realidad, emitir juicios de valor y facilitar la toma de decisiones (Sanmartí, 2007). Constituye una de las tareas de mayor complejidad en la docencia y nos permite comprender y mejorar las prácticas que aborda (Santos, 2007). De manera generalizada, en la práctica docente se evalúa muy poco y se examina mucho, a pesar de que el alumnado consigue un elevado aprendizaje a través de determinados procesos de evaluación (Álvarez, 2001; Hamodi et al., 2015). Con el fin de que tal hecho se revierta, surge y avanza la evaluación formativa en los distintos contextos de la educación.

En el ámbito universitario, este modelo se considera una estrategia de evaluación dirigida a promover autorreflexión y control sobre el propio aprendizaje. Con ella, el estudiante se hace consciente de cómo aprende, qué tiene que hacer para seguir aprendiendo y qué debe reforzar durante el proceso de aprendizaje (Brown & Pickford, 2013; López-Pastor, 2009; Moraza, 2007). El docente se posiciona como un guía para el estudiante y, gracias a este proceso dialógico, la evaluación formativa se convierte, también, en compartida.

La evaluación formativa y compartida y la competencia docente en la Educación Superior

Este tipo de evaluación se desarrolla en mayor medida en la Educación Superior con la creación del Espacio Europeo de Educación Superior (EEES), donde los exámenes pasan a ser solo una parte del sistema para la adquisición de competencias. La competencia docente es entendida como conjunto de conocimientos y capacidades que permiten desarrollar la actividad profesional de la docencia y exige un modelo de evaluación formativa (Martínez & Echevarría, 2009). La evaluación compartida y formativa propicia una solución visionaria a las nuevas bases del sistema establecido (López-Pastor, 2012). Todo esto se encuentra en armonía con numerosos autores que confirman la viabilidad de desarrollar asignaturas en la universidad con sistemas de evaluación continua, formativa y compartida, claramente orientada al aprendizaje del alumnado (Busca et al., 2010). Aunque es una temática reciente, ya existen estudios en los que se observan las ventajas de aplicar programas de evaluación formativa (e.g. Barberá, 2003; Boud & Falchikow, 2007; Knight, 2005; López-Pastor, 2009). Entre ellos destacan aquellos que relacionan la implementación de sistemas de evaluación formativa con mejores resultados académicos e implicación de los estudiantes (Arribas, 2012; Castejón et al., 2011; Lizandra et al., 2017); los que los relacionan con la mejora de su motivación (Manrique et al., 2012); y los que observan en los estudiantes una mayor participación (Busca et al., 2010). Los posibles inconvenientes detectados radican en una mayor carga de trabajo para el profesor y el alumnado y una falta de costumbre en este tipo de sistemas de evaluación (Manrique et al., 2012). Igualmente, se encuentra que los docentes, a veces, pueden percibir su evaluación como más formativa y los estudiantes como más tradicional (Gutiérrez et al., 2013).

Es necesario remarcar que estos estudios utilizan en ocasiones los estudios de caso (Hamodi & López, 2012) y los estudios de investigación-acción, en los que se aplican programas de evaluación formativa y se estudian los resultados en el aprendizaje del alumnado, sus ventajas y sus dificultades (Manrique et al., 2012). También son frecuentes los estudios que utilizan estrategias metodológicas de tipo cuantitativo (e.g. Arribas et al., 2010; Gutiérrez et al., 2013; Hortigüela et al., 2014; Hortigüela et al., 2015; Hortigüela & Pérez-Pueyo, 2016; Palacios & López-Pastor, 2013; Romero-Martín et al., 2017) y de tipo cualitativo (e.g. Busca et al., 2010; Hamodi & López, 2012; Martínez & Flores, 2014; Ureña & Ruiz, 2012). Se publican también, aunque en menor medida, estudios con metodología mixta. Un ejemplo de ellos es el estudio multicaso de corte naturalista de Castejón et al. (2011), en el que se analiza el rendimiento académico y la evaluación formativa en estudiantes de profesorado. Esta variedad metodológica advierte de la complejidad del objeto de estudio y de la necesidad de conocer y comprender el fenómeno desde distintas perspectivas.

La evaluación formativa y compartida en la formación del profesorado de Educación Física

La implementación y características de los sistemas de evaluación en Educación Superior cobra una especial importancia en la formación. Ha sido generalmente admitido que existe una tendencia a reproducir los modelos de evaluación que se han recibido durante la formación, perpetuando los mismos sistemas de evaluación de corte tradicional y obstaculizando la orientación de los mismos hacia el aprendizaje y la mejora (López-Pastor & Sicilia-Camacho, 2015). Según estos autores, los sistemas de evaluación más tradicionales en la formación inicial del profesorado pueden tener un efecto perjudicial, más allá de la propia universidad, ya que los estudiantes serán un día profesores que reproducirán con alta probabilidad los modelos recibidos.

Por ello, fomentar la implementación de sistemas de evaluación formativos en la formación del profesorado debería de ser una prioridad, dada su repercusión social. Porque vivenciar como estudiante sistemas de evaluación formativa y compartida influye positivamente en el posterior desempeño de la función docente, aunque estas experiencias son indudablemente escasas (Hamodi et al., 2017; Molina & López-Pastor, 2019).

La realidad en cuanto a los sistemas de evaluación en la formación del profesorado indica que aún queda mucho camino por recorrer. Bien es cierto que se ha observado una evolución positiva de las prácticas de evaluación formativa y compartida en la docencia universitaria, aunque todavía se hace necesaria la insistencia en implementar estas prácticas (Romero-Martín et al., 2017) o mejorarlas, ya que a veces se utilizan sistemas de evaluación formativa que apenas involucran al alumnado (Gallardo-Fuentes et al., 2017). Esto puede deberse a las diferencias en la percepción de la evaluación de estudiantes y profesorado.

En el ámbito de la formación inicial de la Educación Física, Martínez et al. (2017) mantienen la existencia de tal diferencia de percepción y descubren que la ausencia de planteamientos compartidos en la evaluación se debe a la falta de tiempo, según el docente, y a la falta de interés del docente, según el alumnado. Romero-Martín et al. (2017) también observaron disparidad entre los sistemas de evaluación utilizados y los que la literatura considera como más adecuados para optimizar el aprendizaje y la adquisición de competencias. Esto podría explicar la poca experiencia de los estudiantes de formación inicial del profesorado de Educación Física en recibir sistemas de evaluación formativa y compartida (López-Pastor et al., 2016). No obstante, la implementación de sistemas de evaluación formativa en la formación inicial del profesorado de Educación Física se valora muy positivamente por los estudiantes dada su gran transferencia al desarrollo profesional (López-Pastor et al., 2016), su capacidad de aumentar la motivación en el alumnado, de aportar un aprendizaje mayor (Carrere et al., 2017; Hortigüela et al., 2015; Lizandra et al., 2017), y de más calidad y mayor justicia, en comparación con otros sistemas (Atienza et al., 2016).

Sin embargo, son minoritarios los estudios que analizan los sistemas de evaluación de las asignaturas en la formación inicial del profesorado de Educación Física en Educación Secundaria a través de sus guías docentes. En España, país en el que se contextualiza el estudio, la formación inicial del profesorado en Secundaria se desarrolla a nivel de Máster en distintos bloques formativos. Tampoco se ha profundizado en lo relativo a las diferencias de evaluación de sus distintos bloques. Parece que el bloque formativo de carácter general, que se compone de asignaturas de educación, y, el de carácter específico, que incluye asignaturas específicas de Educación Física, no tienen perspectivas similares. Se necesita saber si el profesorado sigue anclado en sistemas de evaluación tradicionales o si está evolucionando hacia los nuevos modelos emergentes. En concreto, si está atendiendo a las competencias y focalizándose en la utilidad de la evaluación para el aprendizaje, tal y como pretende la evaluación formativa y compartida. Por ello, en este trabajo se realiza un estudio de caso en el Máster de profesorado con especialidad de Educación Física. Se pretende explorar su sistema de evaluación, de modo que pueda profundizarse en el conocimiento de este contexto particular y sirva de orientación para el análisis de contextos de características similares. Igualmente, que se avance en la evidencia para orientar mejor las decisiones programáticas futuras en ambos bloques formativos.

Concretamente, el objetivo del presente estudio es doble: por un lado, analizar los sistemas de evaluación presentes en guías docentes del Máster Universitario en Profesorado de Educación Secundaria Obligatoria, Bachillerato, Formación Profesional y Enseñanzas de Idiomas, Artísticas y Deportivas, de la especialidad de Educación Física de una universidad pública española, bajo el prisma de la evaluación formativa y las competencias docentes, diferenciando asignaturas de carácter general (no específicas de Educación Física) y de carácter específico (relacionadas directamente con la materia de Educación Física); por otro lado, explorar las percepciones de profesores sobre los sistemas de evaluación de dicho Máster.

Metodología

Contexto y diseño del estudio

El Máster objeto de estudio es un máster ofertado por una universidad pública española. En los cursos 2017-2018, 2018-2019 y 2019-2020 ofreció 20 plazas y su estructura se organizó en seis asignaturas de carácter genérico, seis asignaturas de carácter específico, Practicum y Trabajo fin de Máster.

El trabajo de investigación fue un estudio de caso con un tipo de diseño mixto complementario, pues aparecen conjuntamente componentes cuantitativos y cualitativos (Cresswell & Plano, 2011). La elección de dicho diseño se justificó por la mejora del producto final al enriquecerse los métodos entre sí (Ruiz, 2012) y por ser una excelente alternativa para abordar temáticas de investigación educativa (Pereira, 2011).

Muestra y participantes

La muestra utilizada para el estudio cuantitativo se constituyó por la totalidad de las guías docentes de las asignaturas del “Máster de Profesorado de Educación Secundaria” (Especialidad Educación Física), a excepción de “Practicum” y “Trabajo de Fin de Máster” por tener métodos y sistemas de evaluación diferenciados. Finalmente, fueron 12 las que se integraron en el estudio.

En el estudio cualitativo, de un total de doce docentes que impartieron clase en dicho máster, en asignaturas específicas y generales (8 hombres y 4 mujeres), participaron cinco docentes. La media de la edad fue de 54 años (±21), la media de los años de experiencia en la profesión fue de 21 (±17) y en relación al sexo fueron 4 hombres y 1 mujer. Se observaron tres perfiles de categoría profesional: Profesor Titular, Profesor Contratado Doctor y Profesor Asociado. Tres profesores impartían docencia en el título desde su implantación y dos de ellos desde hacía dos años. Todos estaban en posesión del título de Doctor.

Para la selección de los participantes se empleó el muestreo no probabilístico intencional, al conocer previamente las características de los individuos (Alaminos & Castejón, 2006) y priorizando la heterogeneidad de género y categoría profesional. El número de casos escogidos no fue prioritario, siendo el potencial de cada caso lo importante para ayudar al investigador (Taylor & Bogdan, 2013).

Instrumentos

Para el estudio cuantitativo se utilizó el instrumento IASEG (Instrumento de análisis de los sistemas de evaluación de las guías docentes) validado por los miembros de la Red de Evaluación Formativa y Compartida en Educación (REFYCES) (Romero-Martín et al., 2020). Dicho instrumento consta de 37 ítems agrupados en cuatro dimensiones –modalidad de evaluación, agente que evalúa, retroalimentación implícita o explícita y medios-. Esta última dimensión se subdivide en cinco subdimensiones (exámenes o pruebas escritas, sesiones, trabajos en grupo, trabajos individuales y otros medios). A partir de ellas y de los ítems que las integran se obtiene un índice que informa sobre la captación de competencia de ese sistema por medio de la evaluación formativa (ICCD). Para el estudio cuantitativo, basado en el análisis de las guías docentes, se utilizó el instrumento IASEG. Esta herramienta calcula inicialmente una cifra –valor real (VR)- para cada una de las dimensiones, que se traduce en un ICCD por dimensión, de grado alto, medio o bajo, según el valor real máximo que establece la herramienta. Finalmente, permite obtener un ICCD global de cada asignatura expresado en una puntuación entre 0 y 100 puntos. El instrumento dispone de una guía de acompañamiento que facilita la labor del investigador (Romero-Martín et al., 2020). Esta herramienta permite analizar el sistema de evaluación utilizado en una asignatura a partir de la información disponible en la guía docente universitaria, desde el prisma de la evaluación formativa y su capacidad de captación de competencia.

En el estudio cualitativo, el medio de obtención de la información fue la entrevista en profundidad. Se estructuró en cuatro áreas de observación genéricas: sistema de evaluación, retroalimentación, agentes evaluadores, medios e instrumentos. Las preguntas abiertas, conformadas por expresiones que invitaban a conversar, fueron utilizándose de modo informal según el relato de los entrevistados. Se realizaron por una investigadora experta en metodología cualitativa y se grabaron íntegramente con dos dispositivos digitales.

Procedimiento

Para proceder a la recogida de datos del estudio cuantitativo, se consultaron las guías docentes de las doce asignaturas estudiadas, cuyo acceso es público. Cada guía se revisó por dos investigadores con el instrumento IASEG para aumentar la fiabilidad de los resultados. Posteriormente, y una vez dirimidos los desacuerdos con un tercer experto, se procedió al análisis de los datos con el instrumento IASEG, pudiendo comprobar la presencia o no en la evaluación de los elementos que aparecen en el instrumento. Una vez obtenido el índice para cada una de las dimensiones, se calcularon los cuartiles en base a los valores de ICCD, con el fin de situar las diferentes asignaturas. Se estudiaron las diferencias entre asignaturas según su ICCD y según cada una de las dimensiones.

En cuanto a la toma de datos del estudio cualitativo, primero se analizaron las características de la población de estudio (género, edad, antigüedad y tipo de contrato) y se contactó con los docentes para solicitar su participación. Se recogió un consentimiento informado y se realizaron las entrevistas de modo individual en la propia Universidad, teniendo una duración media de cuarenta minutos. Para conseguir la máxima credibilidad en el estudio, se grabaron y transcribieron las entrevistas y los participantes leyeron la transcripción para mostrar su acuerdo o añadir las correcciones pertinentes. El procedimiento de gestión de datos siguió lo establecido en el proyecto que ampara este estudio; este último obtuvo el dictamen favorable del Comité de Ética de Investigación con referencia C.P.-C.I.PI21/377.

Análisis de datos

El análisis de las guías docentes se realizó por dos expertos universitarios de modo independiente y para estudiar el grado de acuerdo entre investigadores se calculó el coeficiente kappa de Cohen. Se alcanzó un alto grado de acuerdo en todos los análisis de las guías (Kappa = 0.92). El cálculo del ICCD se realizó mediante el procedimiento propuesto por los autores del IASEG (Romero-Martín et al., 2020). Para el análisis estadístico se calcularon los cuartiles tomando los valores del ICCD de las asignaturas. Se realizó el Test de Shapiro-Wilk y el Test de Levene confirmando la normalidad y homogeneidad de varianzas a un nivel de significación del 5%. Se utilizó t de Student para muestras independientes con la intención de comparar las medias del ICCD de las asignaturas específicas y de las generales. Sin embargo, no se confirmó tal normalidad en el caso de algunas de las dimensiones y subdimensiones, analizándolas por separado. Por ello, para el estudio de las diferencias por dimensiones, se empleó el Test de Wilcoxon-Mann-Whitney, a excepción de la dimensión otros medios, en la que se utilizó t de Student para muestras independientes. Para el análisis de datos cuantitativos, se empleó el programa SPSS (versión 23.0).

En cuanto a la información recogida en las entrevistas, se utilizó el software de investigación cualitativa NVivo 11 (Sabariego, 2018) y se realizó un análisis de contenido basado en un enfoque constructivista (Bardin, 1986). Los datos se organizaron mediante la codificación y reducción a categorías (Ruiz, 2012). Por un lado, en cuanto a la codificación, se asoció un número a cada entrevistado. Por otro lado, se establecieron las unidades de información asociadas a las categorías tanto existentes previamente como emergentes de los datos. A partir de ellas, se realizó una proposición de síntesis, que finalizó con una interpretación. Así mismo, la información almacenada por las entrevistas no solo permitió contrastar los datos con los obtenidos tras el análisis de las guías docentes, sino que también aportó nuevos matices a la investigación dotándola de mayor credibilidad y confiabilidad.

Resultados

Los resultados hallados a partir del ICCD muestran una gran diferencia entre asignaturas en cuanto a la utilización de la evaluación formativa, al obtenerse 74.62 puntos, en una escala de 100, en la asignatura más formativa y 25.78 puntos, en una escala de 100 puntos máximos, en la menos formativa.

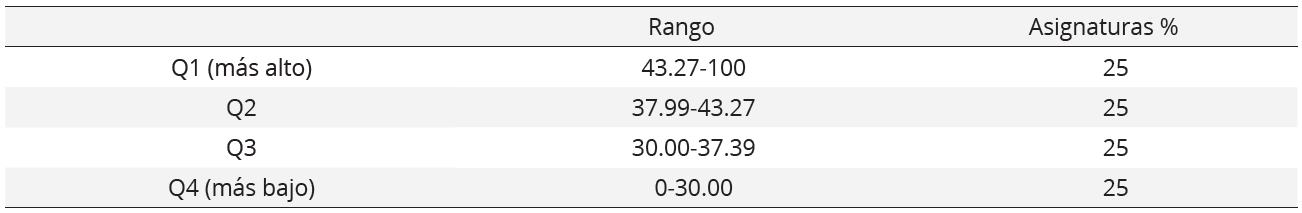

El análisis de los sistemas de evaluación se realizó mediante el cálculo de los cuartiles.

Cuartiles del ICCD y porcentaje de asignaturas de cada uno

A partir de los valores existentes (tabla 1) señalamos que en Q4 (cuartil más bajo) se encuentran tres asignaturas generales que presentan los ICCD de menor puntuación (25.78; 26.71; 29.66). En Q3 dos asignaturas son generales (30.12; 35.51) y una específica (33.75). En Q2 tres asignaturas son específicas (40.48; 41.02; 41.12). Y en Q1 (cuartil más alto) encontramos dos asignaturas específicas (57.73; 74.62) y una general (49.73).

Para presentar un mayor detalle, se analizaron los resultados del ICCD de las doce asignaturas en las dimensiones y subdimensiones del instrumento y se plasman las más destacadas.

En cuanto a la dimensión -modalidad de evaluación-, el 33.33% de las asignaturas presenta la modalidad de evaluación poco formativa al ofrecer únicamente una prueba global (ICCD-dimensión modalidad= 1.62 puntos, sobre una puntuación máxima de 5.48 puntos) y el 66.66% de las asignaturas ofrece, además, una evaluación continua y formativa (ICCD-dimensión modalidad = 5,48, que se corresponde con la puntuación máxima).

Con respecto a la dimensión -agente-, todas las asignaturas presentan el mismo valor (3.7 puntos, sobre una puntuación máxima de 15.89 puntos) al utilizar como agente evaluador solamente al docente.

En la dimensión de –retroalimentación-, el 33.33% de las asignaturas se caracteriza por la ausencia total de retroalimentación (ICCD-dimensión retroalimentación = 0), el 50% de las asignaturas tienen algo de retroalimentación por el feedback implícito en la evaluación continua (ICCD-dimensión retroalimentación = 1.8 puntos, sobre una puntuación máxima de 5.78) y el 16.66% de las asignaturas presentan alto nivel de retroalimentación por presentar feedback explícito (su ICCD-dimensión retroalimentación alcanza la puntuación máxima).

En la dimensión de -medios- en el 8.33% de asignaturas, el carácter de las pruebas es más reproductivo y poco formativo (ICCD-subdimensión exámenes o pruebas escritas = 1.8 puntos, sobre una puntuación máxima de 3.88 puntos), el 75% de las asignaturas utiliza pruebas de mayor aplicación práctica (su ICCD-dimensión exámenes o pruebas escritas llega a la puntuación máxima de 3.88) y en el 16.66% de las asignaturas hay ausencia de estos medios (ICCD-dimensión exámenes o pruebas escritas = 0).

En cuanto a la subdimensión – sesiones-, el 75% de las asignaturas no utiliza este medio (ICCD-subdimensión sesiones = 0), el 8.33% emplea el diseño de sesiones (ICCD-subdimensión sesiones = 4.06 puntos, sobre una puntuación máxima de 15.89 puntos) y el 16.66% utiliza además del diseño la impartición, observación y evaluación/reflexión de estas (el ICCD-subdimensión sesiones obtiene una puntuación máxima).

En la subdimensión de -trabajos en grupo-, el 25% de las asignaturas no emplea este medio (ICCD-subdimensión trabajos en grupo = 0), en el 33.33% de las asignaturas los trabajos en grupo se limitan al nivel teórico (ICCD-subdimensión trabajos en grupo = 9.65 puntos, sobre una puntuación máxima de 10.92) y el 41.66% de las asignaturas realiza trabajos en grupo a nivel teórico-práctico (el ICCD-subdimensión trabajos en grupo alcanza la puntuación máxima).

En cuanto a la subdimensión -trabajos individuales-, el 25% de las asignaturas no utiliza este medio (ICCD-subdimensión trabajos individuales = 0), 25% de las asignaturas lo utiliza, pero a nivel teórico (ICCD-subdimensión trabajos individuales = 9.29 puntos sobre una puntuación máxima de 10.56) y el 50% de las asignaturas lo hace a nivel práctico o teórico-práctico (el ICCD-subdimensión trabajos individuales llega al valor máximo).

En la subdimensión de -otros medios-, la asignatura con menor valor real no emplea medios adicionales (ICCD-subdimensión otros medios = 0) y la asignatura con mayor valor real utiliza seis medios adicionales (ICCD-subdimensión otros medios = 18.21 sobre una puntuación máxima de 31.59 puntos).

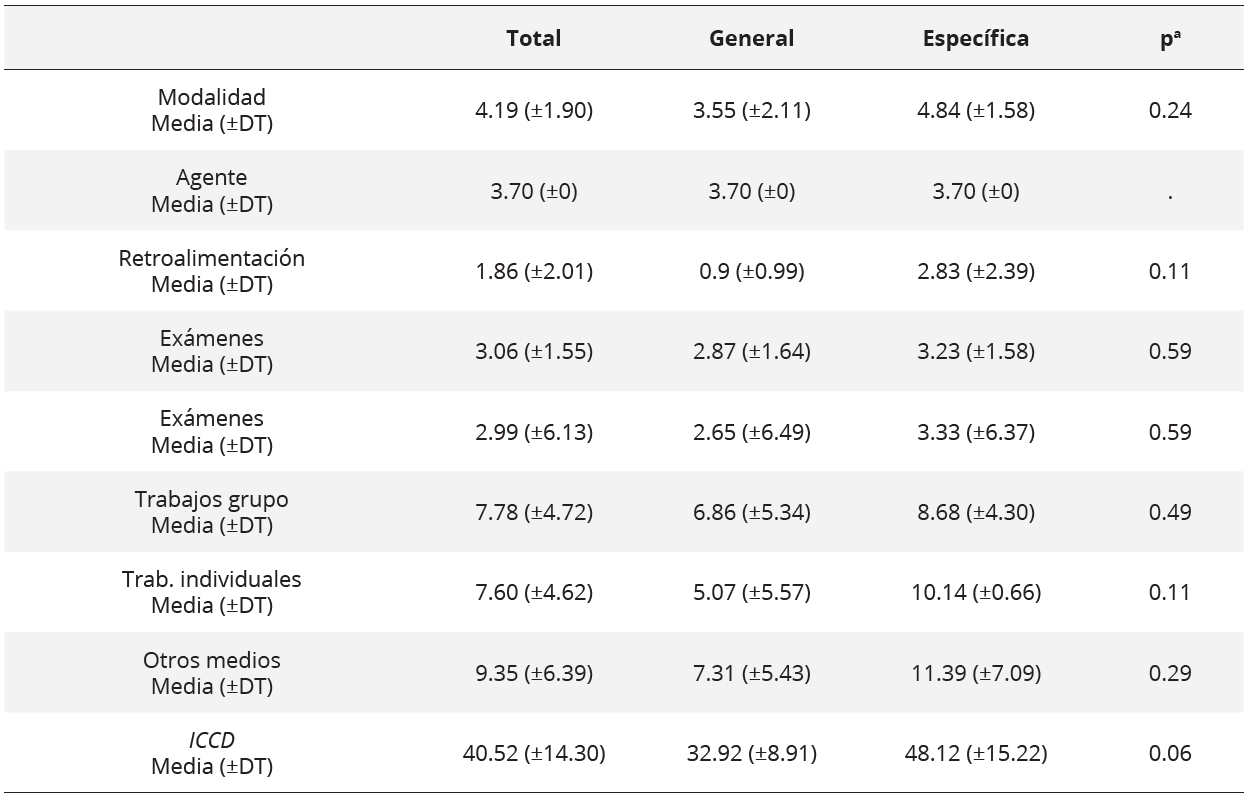

En cuanto a la comparativa entre asignaturas generales y específicas en las diferentes dimensiones y subdimensiones (tabla 2), a partir del promedio del ICCD-dimensión, se observa una igualdad de promedios en la dimensión –agentes- y leves diferencias en las subdimensiones -examen/prueba- y –sesiones-; pero, para el resto de las dimensiones y subdimensiones, las asignaturas específicas muestran un valor indudablemente mayor.

No obstante, los resultados del análisis estadístico no permiten confirmar diferencias significativas entre las asignaturas generales y específicas; si bien, la puntuación en las asignaturas de carácter específico centradas en la Educación Física es más elevada que las de carácter general (tabla 2).

Diferencias en el sistema de evaluación por tipo de asignatura

*Los datos son valores obtenidos en el ICCD en una escala de 0 a 100 y en los ICCD de cada dimensión

*Test T de Student y Test de Wilcoxon-Mann-Whitney.

Del análisis del contenido realizado en el estudio cualitativo se hallaron las siguientes categorías: formación, uso, obstáculos, agentes, instrumentos y medios, retroalimentación y ventajas. De todas ellas se extraen algunas líneas conceptuales que complementan y hacen más comprensible la situación de la evaluación formativa en el Máster.

La primera es la gran variedad en cuanto a la formación de estos docentes en temas relacionados con la evaluación formativa, lo que genera diversidad en la interpretación del significado de evaluación formativa y su implementación en el aula. Los profesores con más formación en esta temática parecen hacer mayor uso de la misma.

“Llevo desde hace unos cuantos años perteneciendo a la Red de Evaluación Formativa y Compartida. Cuando nos juntamos cada año debatimos sobre nuestras experiencias, nos lanzamos a nuevas averiguaciones. Soy muy leído e intento ser muy reflexivo de cada una de las experiencias”. (U15, EIAE)

La segunda es que los docentes entrevistados afrontan la evaluación con una mirada de progreso e innovación que intenta distanciarse de lo puramente tradicional, como son las pruebas finales y reproductivas, a pesar de reconocer no tener suficiente formación en nuevas formas de evaluación.

“Todo lo que sea innovación, mejorar, romper con formas tradicionales es muy importante. Todo lo que sirva para que haya un proceso de aprendizaje acorde a la realidad social es importante”. (U12, EIIIAG)

En tercer lugar, se confirma que el contexto y las exigencias sociales no son garantes de la utilización de la evaluación como instrumento de aprendizaje, sino que más bien este profesorado tiende a la medición, calificación y sanción como único objetivo de la evaluación.

“No es un inconveniente de la evaluación formativa sino de un contexto que no es demasiado formativo al respecto”. (U14, EIAE)

En cuarto lugar, se observa que la evaluación es un elemento de la programación flexible en los casos de este profesorado que incluye sistemas de autoevaluación y coevaluación y que no se refleja en sus guías docentes.

“Tiene bastantes detractores esta idea que yo tengo de la co-evaluación pero me parece que es una buena ocasión el hecho de que, de alguna manera, sean ellos los que participen de la evaluación de sus propios compañeros [...]. Y respecto a la auto-evaluación pues sería un poco lo mismo. En el sentido de que, cada uno es buen conocedor de hasta dónde y de qué manera está avanzando”. (U5, EIAE)

Por último, confirman la existencia de ventajas e inconvenientes en la aplicación de sistemas de evaluación más formativos, al implicar un aprovechamiento del tiempo para que el aprendizaje pueda darse en mayor medida, una mayor implicación del estudiante, así como un aprendizaje continuo a lo largo de la asignatura. No obstante, piensan que las tareas de evaluación formativa que se solicitan a los estudiantes deberían ser más claras y que la retroalimentación debería realizarse durante el proceso y no al finalizar las asignaturas.

“Es que valorar el proceso al final no tiene ningún sentido, por más que te hagan cuatro o todos los informes que tú quieras, si lo que haces es simplemente esperar y cuando tienes todos los informes los revisas. Eso de formativo no tiene nada”. (U6, EVAE)

También perciben que puede generar un mayor esfuerzo y trabajo tanto para el docente como para el estudiante.

Discusión

Los resultados principales del estudio indican que existe diferencia en el carácter formativo de la evaluación de las distintas asignaturas. Aunque no se pueda afirmar que el carácter general o específico de las asignaturas determine su ICCD porque las diferencias no fueron significativas.

Los datos obtenidos desde el diseño de las guías docentes arrojaron que más de la mitad de las asignaturas ofrecían modelos de evaluación continua y formativa y parecía ser debido a esa tendencia del profesorado a hacer el uso de innovaciones en la evaluación huyendo de tendencias más tradicionales con pruebas finalistas y memorísticas y haciendo uso de otros medios de evaluación y sobre todo aportando mucha retroalimentación. No obstante, se comprobó que un tercio de las asignaturas seguía anclado en la modalidad de prueba final, la preferida por el sistema tradicional, si bien el resto se inclinaban hacia una tendencia más formativa.

En los datos del estudio también se observaron diferencias en cuanto a formación e interpretación de la evaluación formativa por parte de los docentes, lo que pudo implicar diferencias en el grado de aplicación de la misma en las asignaturas. Dada la relación hallada entre formación y aplicación de la evaluación formativa (Molina & López-Pastor, 2019), es posible que la falta de formación en evaluación formativa de algunos profesores fuese la causa por la que en una parte de las asignaturas del Máster no se integrara una mayor variedad de medios diferenciados de aquellos más tradicionales, como son las pruebas escritas de carácter memorístico.

En este estudio también se ratificó un uso minoritario de la auto-evaluación y la co-evaluación. Aunque la evidencia de la literatura orienta a que la participación de otros agentes de evaluación, además del profesor, mejora los procesos y productos de aprendizaje y se valora positivamente por los discentes (Ibarra et al., 2012) su utilización es minoritaria en la docencia universitaria (Arribas et al., 2010). No obstante, también se detectó que en este caso podría existir un uso de la auto-evaluación y de evaluación entre iguales que no fuese explicitado por los profesores en sus guías docentes. Así mismo, se detectó que no toda la información sobre los instrumentos de evaluación de la asignatura está presente en estas guías.

En los sistemas de evaluación analizados en las guías docentes en este estudio se apreció una falta total o parcial de retroalimentación, siendo este asunto un claro indicio de que en este caso la evaluación formativa para el aprendizaje no se está produciendo en la medida necesaria. La evaluación formativa implica necesariamente un feedback formativo mientras que la utilización de calificaciones en la evaluación formativa solo tiene cabida si van acompañadas de su correspondiente feedback hacia el estudiante (Boud & Falchikov, 2007). También es cierto que en la guía docente podría no aparecer reflejado el nivel de retroalimentación que un docente realiza de modo más espontáneo durante el desarrollo de su docencia.

En cuanto a los medios de evaluación, el carácter reproductivo de exámenes o trabajos que se observa en este estudio no resulta demasiado formativo. En la misma línea, López-Pastor (2009) asegura que la mayoría de los medios de evaluación utilizados en las universidades son pruebas de respuesta memorística o de resolución de problemas alejados de la realidad profesional. De hecho, en este estudio solo un 25% de las asignaturas utilizaron el diseño o implementación de sesiones en sus sistemas de evaluación, lo que evidencia esa distancia entre la realidad profesional y el proceso formativo.

En el presente estudio, salvo excepciones, las asignaturas específicas utilizaron mayor número y variedad de medios. La utilización de diferentes medios de evaluación que permiten el desarrollo de distintas competencias es clave en la docencia. En la literatura encontramos gran diversidad de medios, como por ejemplo en el estudio de Hamodi et al. (2015), a partir de Castejón et al. (2009) y Rodríguez e Ibarra (2011).

En este estudio se detectó diversidad en la implementación de evaluación formativa. Resulta interesante relacionar esto con la idea de la necesidad de formación permanente entre el profesorado universitario. Algunos estudios intentan acercarse a la problemática y arrojan luz sobre la dificultad general del profesorado para participar en formación docente permanente. Entre ellas se destacan las dificultades para acudir a actividades formativas por incompatibilidad horaria o falta de tiempo (Jato et al., 2014) y la resistencia al cambio por parte del profesorado (Bergman, 2014; Hamodi et al., 2017; Zaragoza et al., 2008).

En cuanto a las consideraciones del profesorado entrevistado en este Máster, decir que las ventajas que encontraron con el uso de la evaluación formativa fueron: aprovechamiento del tiempo para el aprendizaje, mayor participación e implicación del estudiante, tal y como se ratifica también en el estudio de López-Pastor (2009), y mejor asimilación de conceptos a lo largo de todo el proceso, como se evidencia también en distintos estudios (e.g. Barberá, 2003; Boud & Falchikow, 2007; Knight, 2005; Ureña & Ruiz, 2012; Zaragoza et al., 2008).

Conclusiones

El diseño de las guías docentes de las asignaturas del Master refleja heterogeneidad en la presencia de evaluación formativa, sin que se hayan constatado diferencias significativas entre las asignaturas de carácter general y de carácter específico. No obstante, durante el desarrollo de las asignaturas ese carácter formativo de la evaluación podría ser mayor que el observado en el propio diseño de las guías docentes, como relatan los profesores mencionando el uso de la co-evaluación y la autoevaluación de una forma espontánea.

Sin embargo, el estudio arroja aspectos interesantes para seguir avanzando en la investigación como que los tipos de asignaturas en el master podrían ser menos determinantes para la interpretación y el uso de la evaluación formativa que la propia formación del profesorado, las exigencias sociales, las creencias y el contexto. De hecho, el profesorado reconoce las ventajas del uso de este tipo de evaluación, lo que resulta algo contradictorio e interesante como nueva línea de investigación.

En cuanto a las posibles limitaciones de este estudio decir en primer lugar, que se parte del análisis de las guías docentes, pero que estas podrían no ser fieles a la realidad dado que el profesorado suele flexibilizarlas. En segundo lugar, que no fueron entrevistados todos los profesores de este Máster existiendo una gran variedad comportamental en el profesorado en cuanto a la evaluación. Y en último lugar, que quizás existiese una muestra demasiado escasa para encontrar diferencias entre los tipos de asignaturas del Máster y el uso de la evaluación formativa.

Finalmente, resaltar que, dada la gran repercusión que el uso de la evaluación formativa puede tener en los futuros profesores y en los futuros estudiantes de Educación Física, se considera necesario profundizar en la línea de investigación que analice los sistemas de evaluación que se emplean en la actualidad en toda la formación del profesorado de Educación Física de Secundaria, tanto en las guías docentes como en la realidad, y accediendo al mayor número posible de datos y de informantes.

Financiación

Este estudio fue financiado con el proyecto de investigación: "Evaluación de competencias en proyectos de fin de estudios en formación inicial de profesorado de Educación Física" (ref: RTI2018-093292-B-I00) con financiación desde el Programa Estatal de I+D+i Orientada a los Retos de la Sociedad en el marco del Plan Estatal de Investigación Científica y Técnica y de Innovación 2017-2020.

Referencias

Alaminos, A., & Castejón, J. (2006). Elaboración, análisis e interpretación de encuestas, cuestionarios y escalas de opinión. Editorial Marfil.

Álvarez, J. M. (2001). Evaluar para conocer, examinar para excluir. Ediciones Morata.

Álvarez, A., González, J., Alonso, J., & Arias, J. (2014). Indicadores centinela para el Plan Bolonia. Revista de Investigación Educativa, 32(2), 327-338. https://doi.org/10.6018/rie.32.2.171751

Arribas, J.M. (2012). El rendimiento académico en función del sistema de evaluación empleado. RELIEVE, 18(1), 1-15. http://www.redalyc.org/articulo.oa?id=91624440003

Arribas, J.M., Carabias, D., & Monreal, I. (2010). La docencia universitaria en la formación inicial del profesorado. El caso de la escuela de magisterio de Segovia. REIFOP, 13(3), 27-35.

Atienza, R., Valencia-Peris, A., Martos-García, D., López-Pastor, V., & Devís-Devís, J. (2016). La percepción del alumnado universitario de educación física sobre la evaluación formativa: ventajas, dificultades y satisfacción. Movimento, 22(4), 1033-1048. http://www.redalyc.org/articulo.oa?id=115349439002

Barberá, E. (2003) Estado y tendencias de la evaluación en educación superior. Revista de la Red Estatal de Docencia Universitaria, 3(2), 47-60.

Bardin, L. (1986). El análisis de contenido. Akal.

Bergman, M. (2014). An international experiment with eRubrics: An approach to educational assessment in two courses of the early childhood education degree. REDU. Revista de Docencia Universitaria, 12(1), 99-110. https://doi.org/10.4995/redu.2014.6409

Boud, D., & Falchikov, N. (2007). Rethinking assessment in Higher Education. Learning for the long term. Routledge.

Brown, S., & Pickforf, R. (2013). Evaluación de habilidades y competencias en educación superior. Narcea.

Busca, F., Pintor, P., Martínez, L., & Peire, T. (2010). Sistemas y procedimientos de evaluación formativa en docencia universitaria. Estudios sobre Educación, 18, 255-276.

Carrere, L. et al. (2017). Descubriendo el enfoque formativo de la evaluación en un curso de Matemáticas para estudiantes de Bioingeniería. REDU. Revista de Docencia Universitaria, 15(1), 325-343. https://doi.org/10.4995/redu.2017.6334

Castejón, J., Capllonch, M., González, N., & López-Pastor, V. (2009). Técnicas e instrumentos de evaluación formativa y compartida para la docencia universitaria. En V. López-Pastor (coord.), Evaluación formativa y compartida en Educación Superior (pp. 65-91). Narcea.

Castejón, F., López-Pastor, V., Julián, J., & Zaragoza, J. (2011). Evaluación formativa y rendimiento académico en la Formación inicial del profesorado de Educación Física. Revista Internacional de Medicina y Ciencias de la Actividad Física y el Deporte, 11(42), 328-346. http://cdeporte.rediris.es/revista/revista42/artevaluacion163.htm

Creswell, J., & Plano, V. (2011). Designing and conducting mixed methods research. Sage Publications.

Cook, T., & Reichardt, C. (1986). Métodos cualitativos y cuantitativos en investigación evaluativa. Ediciones Morata.

Gallardo-Fuentes, F., López-Pastor, V., & Carter, B. (2017). ¿Hay evaluación formativa y compartida en la formación inicial del profesorado en Chile? Percepción de alumnado, profesorado y egresados de una universidad. Psychology, Society, & Education, 9(2), 227-238. https://doi.org/10.25115/psye.v9i2.699

Gutiérrez, C., Pérez-Pueyo, Á., & Pérez-Gutiérrez, M. (2013). Percepciones de profesores, alumnos y egresados sobre los sistemas de evaluación en estudios universitarios de formación del profesorado de educación física. Ágora para la Educación Física y el Deporte, 15(2), 130-151.

Hamodi, C., & López, A. (2012). La evaluación formativa y compartida en la Formación Inicial del Profesorado desde la perspectiva del alumnado y de los egresados. Psychology, Society, & Education, 4(1), 103-116. https://core.ac.uk/download/pdf/143458581.pdf

Hamodi, C., López-Pastor, V., & López-Pastor, A. (2015). Medios, técnicas e instrumentos de evaluación formativa y compartida en Educación Superior. Perfiles Educativos, 37(174), 146-161. http://www.scielo.org.mx/scielo.php?script=sci_arttext&pid=S0185-26982015000100009&lng=es&nrm=iso

Hamodi, C., López-Pastor, V., & López-Pastor, A. (2017). If I experience formative assessment whilst studying at university, will I put it into practice later as a teacher? Formative and shared assessment in Initial Teacher Education (ITE). European Journal of Teacher Education, 40(2), 171-190. https://doi.org/10.1080/02619768.2017.1281909

Hortigüela, D., Abella, V., & Pérez-Pueyo, A. (2014). Perspectiva del alumnado sobre la evaluación tradicional y la evaluación formativa. Contraste de grupos en las mismas asignaturas. Revista Iberoamericana sobre Calidad, Eficacia y Cambio en Educación, 13(1), 1-14.

Hortigüela, D., Abella, V., & Pérez-Pueyo, A. (2015). Percepciones del alumnado sobre la evaluación formativa: Contraste de grupos de inicio y final de carrera. REDU. Revista de Docencia Universitaria, 13(3), 13-32. https://doi.org/10.4995/redu.2015.5417

Hortigüela, D., & Pérez-Pueyo, A. (2016). Percepción del alumnado de las clases de educación física en relación con otras asignaturas. Apunts, 123, 44-52. http://dx.doi.org/10.5672/apunts.2014-0983.es.(2016/1).123.05

Ibarra, M., Rodríguez, G., & Gómez, M. (2012). La evaluación entre iguales: beneficios y estrategias para su práctica en la universidad. Revista de Educación, 359, 206-231. http://dx.doi.org/10-4438/1988-592X-RE-2010-359-092

Jato, E., Muñoz, M., & García, B. (2014). Las necesidades formativas del profesorado universitario: un análisis desde el programa de formación docente de la Universidad de Santiago de Compostela. REDU. Revista de Docencia Universitaria, 12(4), 203-229. https://doi.org/10.4995/redu.2014.5621

Knight, P. (2005). El profesorado de Educación Superior. Narcea.

Lizandra, J., Valencia-Peris, A., Atienza Gago, R., & Martos-García, D. (2017). Itinerarios de evaluación y su relación con el rendimiento académico. REDU: Revista de Docencia Universitaria, 15(2), 315-328. https://doi.org/10.4995/redu.2017.7862

López, M., Pérez-García, M., & Rodríguez, M. (2015). Concepciones del profesorado universitario sobre la formación en el marco del espacio europeo de educación superior. Revista de Investigación Educativa, 33(1), 179-194. https://doi.org/10.6018/rie.33.1.189811

López-Pastor, V. (2009). Evaluación formativa y compartida en Educación Superior. Propuestas, técnicas, instrumentos y experiencias. Narcea.

López-Pastor, V., Pérez-Pueyo, A., Barba, J., & Lorente-Catalán, E. (2016). Percepción del alumnado sobre la utilización de una escala graduada para la autoevaluación y coevaluación de trabajos escritos en la formación inicial del profesorado de educación física (FIPEF). Cultura, Ciencia y Deporte, 11(31), 37-50. http://www.redalyc.org/articulo.oa?id=163044427005

López-Pastor, V., & Sicilia-Camacho, A. (2015). Formative and shared assessment in higher education. Lessons learned and challenges for the future. Assessment & Evaluation in Higher Education, 42(1), 77–97. https://doi.org/10.1080/02602938.2015.1083535

Manrique, J., Vallés, C., & Gea, J. (2012). Resultados generales de la puesta en práctica de 29 casos sobre el desarrollo de sistemas de Evaluación formativa en docencia universitaria. Psychology, Society & Educatión, 4(1), 87-102.

Martínez, L., Castejón, F., & Santos, M. (2012). Diferentes percepciones sobre evaluación formativa entre profesorado y alumnado en formación inicial en educación física. Revista Electrónica Interuniversitaria de Formación del Profesorado, 15(4), 57-67.

Martínez, L., & Flores G. (2014). Profesorado y egresados ante los sistemas de evaluación del alumnado en la formación inicial del maestro en educación infantil. RIDU, 1. https://doi.org/10.19083/ridu.8.371

Martínez, L., Santos, L., & Castejón, F. (2017). Percepciones de alumnado y profesorado en Educación Superior sobre la evaluación en formación inicial en educación física. Retos, 32, 76-81.

Martínez, P., & Echevarría, B. (2009): Formación basada en competencias. Revista de Investigación Educativa, 27(1), 125-147.

Molina, M., & López-Pastor, V. (2019). ¿Evalúo cómo me evaluaron en la Facultad? Transferencia de la evaluación formativa y compartida vivida durante la formación inicial del profesorado a la práctica como docente. Revista Iberoamericana de Evaluación Educativa, 12,1, 85-101. https://doi.org/10.15366/riee2019.12.1.005

Moraza, J. (2007). Utilidad Formativa del Análisis de Errores Cometidos en Exámenes (Tesis doctoral). Universidad de Burgos, España.

Palacios, A., & López-Pastor, V. (2013). Haz lo que yo digo pero no lo que yo hago: sistemas de evaluación del alumnado en la formación inicial del profesorado. Revista de Educación, 361. https://doi.org/10-4438/1988-592X-RE-2011-361-143

Panadero, E., Fraile, J., Ruiz, J.F., Castilla-Estévez, J., & Ruiz, M. A. (2018). Spanish university assessment practices: examination tradition with diversity by faculty. Assessment & Evaluation in Higher Education. https://doi.org/10.1080/02602938.2018.1512553

Pereira, Z. (2011). Los diseños de método mixto en la investigación en educación: Una experiencia concreta. Revista Electrónica Educare, 15(1), 15-29. http://www.redalyc.org/articulo.oa?id=194118804003

Rodríguez, G., & Ibarra, M. (2011). E-Evaluación orientada al e-aprendizaje estratégico en educación superior. Narcea.

Romero-Martín, R., Castejón-Oliva, F., López-Pastor, V., & Fraile-Aranda, A. (2017). Evaluación Formativa, Competencias Comunicativas y TIC en la formación del profesorado. Comunicar, 25(42), 73-82. https://doi.org/10.3916/C52-2017-07

Romero-Martín, R., Asún-Dieste, S., & Chivite-Izco, M. (2020). Diseño y validación de un instrumento para analizar el sistema de evaluación de las guías docentes universitarias en la formación inicial del profesorado (IASEG). Profesorado, Revista de Currículum y Formación del Profesorado, 24(2), 346-367. https://doi.org/10.30827/profesorado.v24i2.15040

Ruiz, J. (2012). Metodología de la Investigación Cualitativa (5th ed.). Publicaciones de la Universidad de Deusto.

Sabariego, M (2018). Análisis de datos cualitativos a través del programa NVivo 11PRO. Universidad de Barcelona.

Sanmartí, N. (2007). 10 ideas clave, evaluar para aprender. GGraó.

Santos, M. A. (2007). La evaluación como aprendizaje: la flecha en la diana. Bonum.

Taylor, S., & Bogdan, R. (2013). Introducción a los métodos cualitativos de investigación. Paidós.

Ureña, N., & Ruiz, E. (2012). Experiencia de evaluación formativa y compartida en el Máster Universitario en Formación del Profesorado de Educación Secundaria. Psychology, Society & Education, 4(1), 29-44.

Zaragoza, J., Luis, J., & Manrique, J. (2008). Experiencias de innovación en docencia universitaria: resultados de la aplicación de sistemas de evaluación formativa. REDU. Revista de Docencia Universitaria, 4, 1-33. https://doi.org/10.4995/redu.2009.6232

Notas de autor

* Autor para la correspondencia: Sonia Asún-Dieste, sonasun@unizar.es

Información adicional

Cómo citar el artículo: Asún-Dieste, S., & Guíu Carrera, M. (2023). Uso de la evaluación formativa en formación del profesorado de Educación Física en Educación Secundaria: un estudio de caso. Cultura Ciencia y Deporte, 18(55). https://doi.org/10.12800/ccd.v18i55.1918

ISSN: 1696-5043

Vol. 18

Num. 55

Año. 2023

Uso de la evaluación formativa en formación del profesorado de Educación Física en Educación Secundaria: un estudio de caso

SoniaMarta Asún-DiesteGuíu Carrera

Universidad de ZaragozaInstituto de Enseñanza Secundaria La Marina,EspañaEspaña